Article partant d’une idée intéressante (prendre le point de vue d’un utilisateur de données avec un besoin réel et suivre son parcours), malheureusement avec un diagnostic et une analyses incorrects.

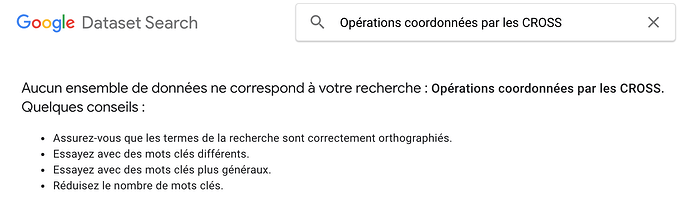

En deux mots-clés, vais-je pouvoir trouver la base de données localisant tous les parkings de Montpellier ? C’est bien la promesse de Google Dataset Search,

Il faut déjà préciser que Google trouvera ces données sur les parkings de Montpellier à deux conditions : 1) si elles existent (duh), et 2) si elles sont découvrables, c’est à dire diffusées et décrites de façon structurée en respectant les standards du web.

Les pages citées dans l’article (celle-ci par exemple) référence une page qui n’existe plus. Plutôt que d’en tirer une quelconque conclusion sur Google, j’en retiens surtout que BRGM ferait bien de nettoyer son catalogue (la page en question n’a pas été mise à jour depuis… 2013). J’ai quand même pris le temps de signaler le lien cassé par le biais du formulaire de contact et j’ai reçu cette réponse du BRGM :

Le Géocatalogue est constitué par moissonnage des catalogues des adhérents au projet.

Votre signalement a été transmis au catalogue d’où est issue cette métadonnée : Occitanie Pyrénées en Intelligence Géomatique (OpenIG http://www.siglr.org/).

Pareil pour cette page où une page a été créée mais aucune donnée publiée, mettant sur une fausse piste les moteurs de recherche et donc les utilisateurs.

Dans ces deux cas, les sites font leur boulot : se rendre découvrable des utilisateurs à travers les moteurs de recherche et exposer les informations telles que renseignées par les producteurs.

A quel moment ça foire alors ?

Le phénomène est en fait très courant et symptomatique du problème de l’open data actuel. Les producteurs s’appuient sur des sites pour rendre visibles leurs données mais considèrent une fois la publication réalisée que le boulot est fait une fois pour toute. Or les données ne sont pas mises à jour, les liens cassent, etc. Les portails ne sont pas branchés aux systèmes métiers où vivent ces données. Les portails ne sont des outils que de publication et de communication, aussi bons que l’usage qu’on en fait.

Le dernier site où atterrit l’utilisatrice est finalement le bon : https://data.montpellier3m.fr/. On y voit la meilleure approche pour un producteur : s’appuyer pour publier ses données sur un outil dont il a l’entière maîtrise et qui est au plus près de ses systèmes métiers. Les jeux de données y sont riches et à jour.

Malheureusement celui-ci ne profite pas pleinement des possibilité du web et n’utilise le markup Dataset nécessaire pour être indexé par Google Dataset Search (et potentiellement tous les autres crawlers qui le souhaitent).

Cette exploration très instructive se conclut par un téléchargement de données OSM, redistribuées par data.montpellier3m.fr.

Les parkings étant des données géographiques par excellence, elles prennent tout leur sens dans OSM. Or, les données OpenStreetMap par définition ne sont pas sur le web. Bref, il faut aussi penser l’open data en dehors du web, donc en dehors des moteurs de recherche, et dans les gisements où elles vivent (base de données métiers, OpenStreetMap, Wikidata/Wikibase, etc.).